Hola.

Recomendaciones:

- mínimo medio giga de memoria dedicada por hilo (no por núcleo) de procesador. Yo le daría al menos 2.

- nvme para todo.

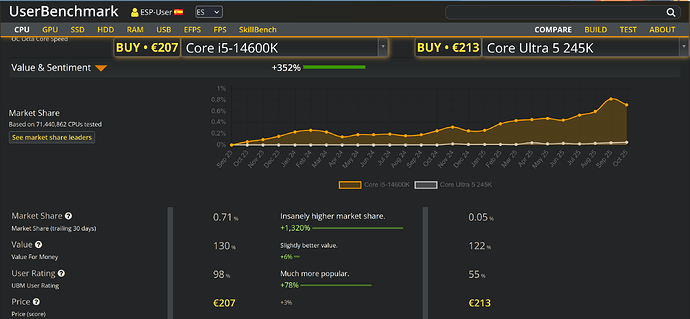

- Si no vas ha hacer overclock no gastes un euro más en algo porque puedas hacer overclock, y cuidado que algunos benchmarks aluden a situaciones de overclock a la hora de hacer las valoraciones.

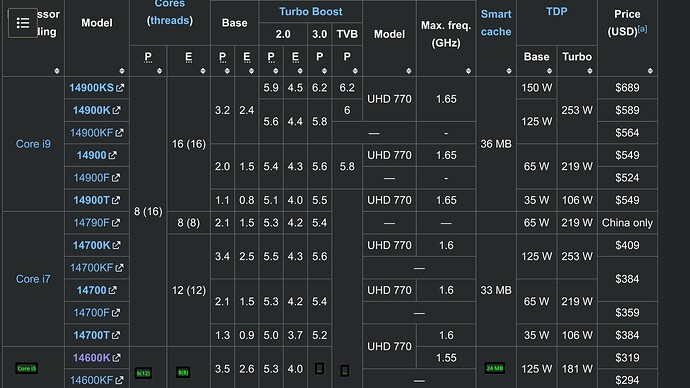

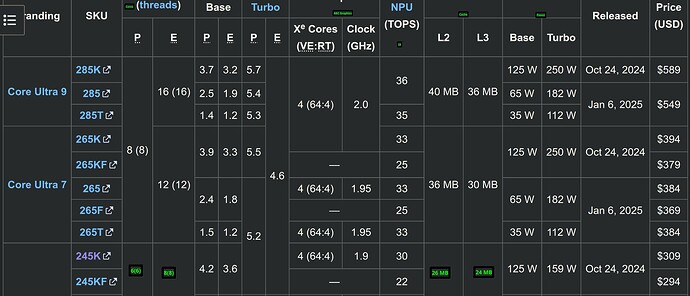

- Con el 14600 no gastes un euro en que la memoria tenga maś de 5600 Hz, el procesador no lo va a advertir, y cuando cambies el procesador no te servirá de mucho una memoria DDR5 de 6400, 7000 o lo que sea. Con el 245 puedes plantearte 6400. A veces es más barata la de más frecuencia, ahí sí.

La teoría

No es fácil entender siquiera cómo funciona el hardware moderno. Cuando estudiaba yo, lo ultimísimo era el Pentium II y ya el propio Pentium tenía cosas que parecían magia

La teoría es sencilla: mayor frecuencia + mayor ancho de banda + menores latencias + mayores memorias.

Imaginad que tenéis dos hilos. Y tenéis un programa que tiene que hacer, ¡qué casualidad! dos operaciones complejas pero independientes. Si escribís el programa de forma correcta, el compilador creará un ejecutable que hará que una operación se resuelva en un hilo y la otra en el otro. Es guay y supereficiente. Podéis buscar ejemplos de código en algún lenguaje interpretable (por sencillez) para probar.

Pero tanto la propia operación como los datos tienen que estar en memoria. Y de la memoria las cosas se envían al procesador, claro. Quieres sumar 10 y 20, envías 10 a un registro del procesador, envías 20 a otro registro, y activas la instrucción “sumar” en el procesador, para que lo que sale del mismo sea el resultado (30) y se envíe a un registro o a la memoria.

Cuando compiláis, por ejemplo, la instrucción variable++ en C y derivados, el compilador crea un ejecutable que hace que el valor de esa variable se copie automáticamente en uno de los registros del procesador.

Entonces desde el punto de vista del procesador, si tienes las cosas en los registros, operas. Si no están en los registros, las copias de la memoria siguiente. Si no están ahí, vas a la otra, y así hasta que no hay más (la última parada es la memoria virtual). Imaginad que necesitáis un operando que está en memoria virtual: el procesador la busca en la caché interna, como no está, busca en la caché externa al microprocesador, si no está y aun hay otra caché la busca ahí, si no está o no hay esa tercera caché la busca en memoria principal, si no está la busca en memoria, si no está en memoria la busca en la virtual; entonces el procesador activa la instrucción del sistema operativo para copiarla a memoria principal, de ahí a las cachés, de ahí a las cachés más internas, y de ahí a los propios registros. No, no hay forma de copiar algo desde el disco a los registros directamente.

Imaginad que tenéis una biblioteca y tu mesa de trabajo. Cuantas más cosas en la mesa (y más grande la mesa) menos necesitas acudir a la biblioteca, así que todo va más rápido. Hasta que llega el momento en que te lleva más tiempo comprobar si algo está o no en la mesa, y si no está irlo a buscar, que lo que te llevaría cogerlo directamente.

Cuando el procesador Pentium encuentra (en versión código máquina) una disyuntiva, por ejemplo, si (condición) haz tal, si no, haz otra cosa, lo que hacía es ejecutar las dos cosas a la vez, como si fuera cierto o no. Luego cuando resolvía la condición ya descartaba lo que ya era innecesario. También era capaz de adelantarse e “ir explorando el código ejecutable”, por ejemplo, infería que había una llamada a una función y la iba ejecutando. Los procesadores modernos hacen mucho más.

El problema es que eso funciona guay cuando el programa de turno está bien escrito, compilado con un buen compilador (por eso veis benchmarks de esos que muestran resultados con diferentes compiladores, en particular en benchmarks de distros Linux) y ejecutado con un sistema operativo bien configurado que responde bien a la versión exacta de los drivers concretos de turno.

Por otra parte los benmarks están bien de referencia, pero son máquinas irreales en el sentido en el que nunca vais a tener el sistema operativo en esas condiciones. Y tampoco habrá la misma temperatura exacta para tu hardware, etc.

Y luego está el kaos. Por ejemplo, Intel lleva tiempo anunciando IA para sus nuevos procesadores. En mi opinión, solo por eso habría que prohibirle la comercialización de procesadores, pero ok. Si os fijáis, la instalación de cualquier sistema de openSUSE activa las mitigaciones por unos viejos problemas de seguridad en sus chips (y a los que no fueron ajenos AMD, que de todo hay). Esas mitigaciones consisten en desactivar funcionalidad, por supuesto!

- Pero eso estará resuelto ya, no?

- ¿Quién os ha dicho eso?

En lugar de centrarse en resolver los problemas previos, Intel los parchea (como he dicho, básicamente es que se deshabilita la funcionalidad de turno) y a la mínima saca “una nueva generación” que añade complejidad. Y ahora la tImoÁ, porque nuestra sociedad capitalista es esto. Tampoco es que AMD sea ajena a esos tocomochos, que ya os veo venir.